Data Science Tools: Die besten Open Source Tools für 2025

Die Welt der Data Science hat in den letzten Jahren eine unglaubliche Entwicklung durchgemacht, auch die Data Science Tools entwickeln sich weiter. Im Jahr 2025 stehen Data Scientists mehr Werkzeuge zur Verfügung als jemals zuvor. Diese Tools dienen der Datenanalyse, Modelle zu entwickeln und Erkenntnisse zu gewinnen. Besonders die Open Source Gemeinschaft hat eine Fülle von leistungsstarken und kostenlosen Tools hervorgebracht. Diese machen Data Science zugänglicher und flexibler . In diesem Artikel werfen wir einen Blick auf die besten Open Source Tools für 2025.

1. Python und seine Bibliotheken als klassisches Data Science Tool

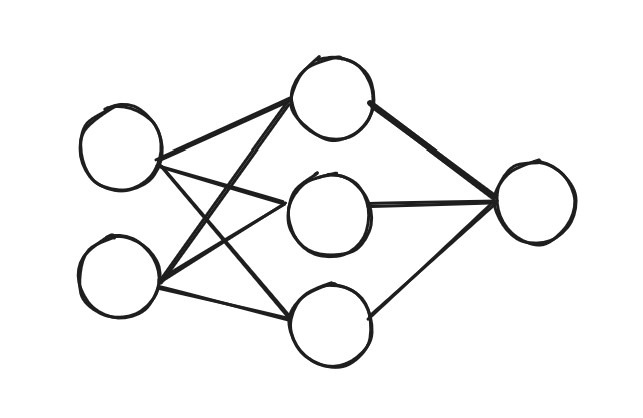

Python bleibt auch 2025 die bevorzugte Sprache für Data Scientists, und das aus gutem Grund. Die riesige Auswahl an Bibliotheken macht Python zu einem Allrounder in der Datenwissenschaft. a) NumPy und Pandas NumPy und Pandas sind weiterhin unverzichtbare Werkzeuge für die Datenmanipulation. NumPy ermögicht effiziente Operationen auf Arrays. Pandas wiederum bietet eine benutzerfreundliche Schnittstelle für den Umgang mit tabellarischen Daten. b) scikit-learn: Dieses Machine Learning Framework ist ideal für Einsteiger und Fortgeschrittene. Denn mit seiner einfachen API kannst du Modelle erstellen, trainieren und bewerten – von Entscheidungsbäumen bis hin zu neuronalen Netzen. c) PyTorch sowie TensorFlow: Für komplexere Machine Learning Modelle und Deep Learning sind PyTorch und TensorFlow die beliebtesten Optionen. Beide bieten umfangreiche Möglichkeiten zur Modellierung und Skalierung.

2. R: Der Klassiker für statistische Analysen

R ist nach wie vor eine der besten Optionen, wenn es um statistische Analysen geht. Mit einer großen Auswahl an Paketen wie ggplot2 für Visualisierung und dplyr für Datenmanipulation ist R speziell für Statistikinteressierte geeignet. RStudio RStudio bleibt die bevorzugte Entwicklungsumgebung für R-Nutzer, weil es Benutzerfreundlichkeit mit leistungsstarken Funktionen kombiniert. Inkludiert ist die Integration von Markdown und Shiny für interaktive Dashboards.

3. Jupyter Notebooks: Interaktive Datenanalyse

Jupyter Notebooks sind das Herzstück vieler Data Science Workflows. Sie bieten eine interaktive Umgebung, in der Code, Visualisierungen und Dokumentation nahtlos kombiniert werden können. JupyterLab Die Weiterentwicklung von Jupyter Notebooks, JupyterLab, bietet eine noch bessere Benutzeroberfläche und mehr Flexibilität. Mit Erweiterungen kannst du beispielsweise SQL Abfragen oder Visualisierungen direkt in der IDE integrieren.

4. Apache Spark: Big Data leicht gemacht

Für die Verarbeitung und Analyse großer Datenmengen bleibt Apache Spark die erste Wahl. Mit seiner Fähigkeit, Daten in verteilten Umgebungen effizient zu verarbeiten, ist Spark ideal für Projekte, die mit Hadoop und anderen Big-Data-Technologien integriert werden müssen. PySpark: Die Python-API von Apache Spark erleichtert die Nutzung von Spark für Python-Entwickler und ermöglicht es, leistungsstarke Datenpipelines zu erstellen.

5. Data Science Tools für Visualisierung: Daten zum Leben erwecken

a) Matplotlib und Seaborn: Diese Python Bibliotheken sind perfekt für die Erstellung von Diagrammen und Visualisierungen. Matplotlib bietet maximale Kontrolle über die Visualisierungen. Seaborn hingegen punktet mit einer einfachen Erstellung von ansprechenden Diagrammen. b) Plotly und Dash: Für interaktive Visualisierungen sind Plotly und Dash unschlagbar. Sie ermöglichen es, interaktive Diagramme zu erstellen, die in Webanwendungen integriert werden können. c) Grafana: Grafana ist eine Open-Source-Plattform, die speziell für die Visualisierung von Zeitreihendaten entwickelt wurde. Sie ist ideal für Monitoring und Dashboards.

6. Datenbanken und Abfragetools

a) PostgreSQL: PostgreSQL bleibt eine der beliebtesten Open-Source-Datenbanken. Mit seiner Stabilität, Skalierbarkeit und Unterstützung für komplexe Abfragen eignet es sich für nahezu jedes Datenprojekt. b) SQLite: Für kleinere Projekte oder prototypische Entwicklungen ist SQLite ideal. Es ist leichtgewichtig und benötigt keine separate Serverinstallation. c) Apache Hive: Für Big-Data-Analysen bietet Apache Hive SQL-ähnliche Abfragemöglichkeiten und integriert sich nahtlos in Hadoop-Umgebungen.

7. Werkzeuge der Datenwissenschaften für Versionskontrolle und Kollaboration

a) Git und GitHub: Git bleibt das Standardwerkzeug für Versionskontrolle, während GitHub eine Plattform für Zusammenarbeit und Open Source Projekte bietet. b) DVC (Data Version Control): Für Datenwissenschaftler, die mit großen Datensätzen arbeiten, ist DVC ein unverzichtbares Tool. Es bietet Versionskontrolle für Datensätze und Machine Learning Modelle. c) Kaggle: Neben der Bereitstellung von Datensätzen ist Kaggle auch eine Plattform für Kollaboration und Wettbewerbe in der Datenwissenschaft.

8. Workflow-Management und Automatisierung

a) Apache Airflow: Airflow ist ein Workflow-Orchestrator, der komplexe Datenpipelines automatisieren kann. Mit seinen benutzerfreundlichen Dashboards und der Python Integration ist es ideal für die Automatisierung wiederkehrender Aufgaben. b) Prefect: Prefect ist eine moderne Alternative zu Airflow, die sich durch eine einfache API und hervorragende Fehlerbehandlung auszeichnet. c) Luigi: Dieses Tool von Spotify bietet eine ähnliche Funktionalität wie Airflow, ist jedoch besonders für kleinere Projekte geeignet.

Fazit: Die Vielfalt der besten Open Source Data Science Tools

Die Open-Source-Welt bietet Data Scientists im Jahr 2025 eine unglaubliche Vielfalt an Tools. Von Python-Bibliotheken über Big-Data-Plattformen bis hin zu Visualisierungstools und Workflow-Management-Software. Es gibt für jede Aufgabe das passende Werkzeug. Der große Vorteil von Open Source liegt nicht nur in den Einsparungen bei den Lizenzkosten. Vielmehr liegt der Mehrwert auch in der starken Community-Unterstützung, die ständige Weiterentwicklungen und Innovationen garantiert. Die Wahl des richtigen Tools hängt von den spezifischen Anforderungen des Projekts ab. Aber eines ist sicher: Mit den oben genannten Werkzeugen bist du bestens gerüstet, um die Herausforderungen der modernen Datenwissenschaft zu meistern.